Publication

L’Intelligence Artificielle peut-elle renforcer les dispositifs de lutte contre le blanchiment des capitaux et le financement du terrorisme (LCB/FT) ?

Le parlement européen est favorable à l’utilisation des nouvelles technologies pour répondre aux obligations réglementaires relatives à la lutte contre le blanchiment des capitaux et le financement du terrorisme (LCB/FT).

En effet, sa considération 19 de la directive (UE) 2015-849 stipule que « les nouvelles technologies offrent aux entreprises et aux clients des solutions rentables et efficaces en termes de temps et devraient dès lors être prises en compte au moment de l’évaluation des risques. Les autorités compétentes et les entités assujetties devraient faire preuve d’initiative dans la lutte contre les méthodes nouvelles et inédites de blanchiment de capitaux. »[1]

Dans ce contexte, les institutions financières investissent significativement dans la digitalisation de leurs opérations. A titre d’exemple, la digitalisation de la connaissance client (Know Your Customer) au cours de l’entrée en relation d’affaires est une démarche bien avancée grâce notamment aux nouvelles technologies telles que le Business Process Management (BPM) et le Robotic Process Automation (RPA).

Dans la même optique, l’utilisation du potentiel qu’offre l’intelligence artificielle et le Machine Learning en particulier est de plus en plus évoquée pour les dispositifs de surveillance et de gestion des risques de blanchiment de capitaux et de financement du terrorisme (BC/FT), notamment en ce qui concerne l’exploitation des données via le Machine Learning pour identifier, évaluer et maîtriser ces risques. Cependant il y a encore très peu d’information sur l’utilisation de ces technologies dans ce cadre.

Après avoir rappelé les composantes d’un dispositif LCB/FT comme attendu par la règlementation, nous balayerons brièvement l’intérêt de l’utilisation de l’IA dans un dispositif LCB/FT. Nous identifierons les zones potentielles d’imbrication du Machine Learning ainsi que les méthodes d’utilisation que l’on peut envisager tout en prenant en considération les limites et risques qu’engendrent cette intégration.

Qu’est-ce qu’un dispositif LCB/FT ?

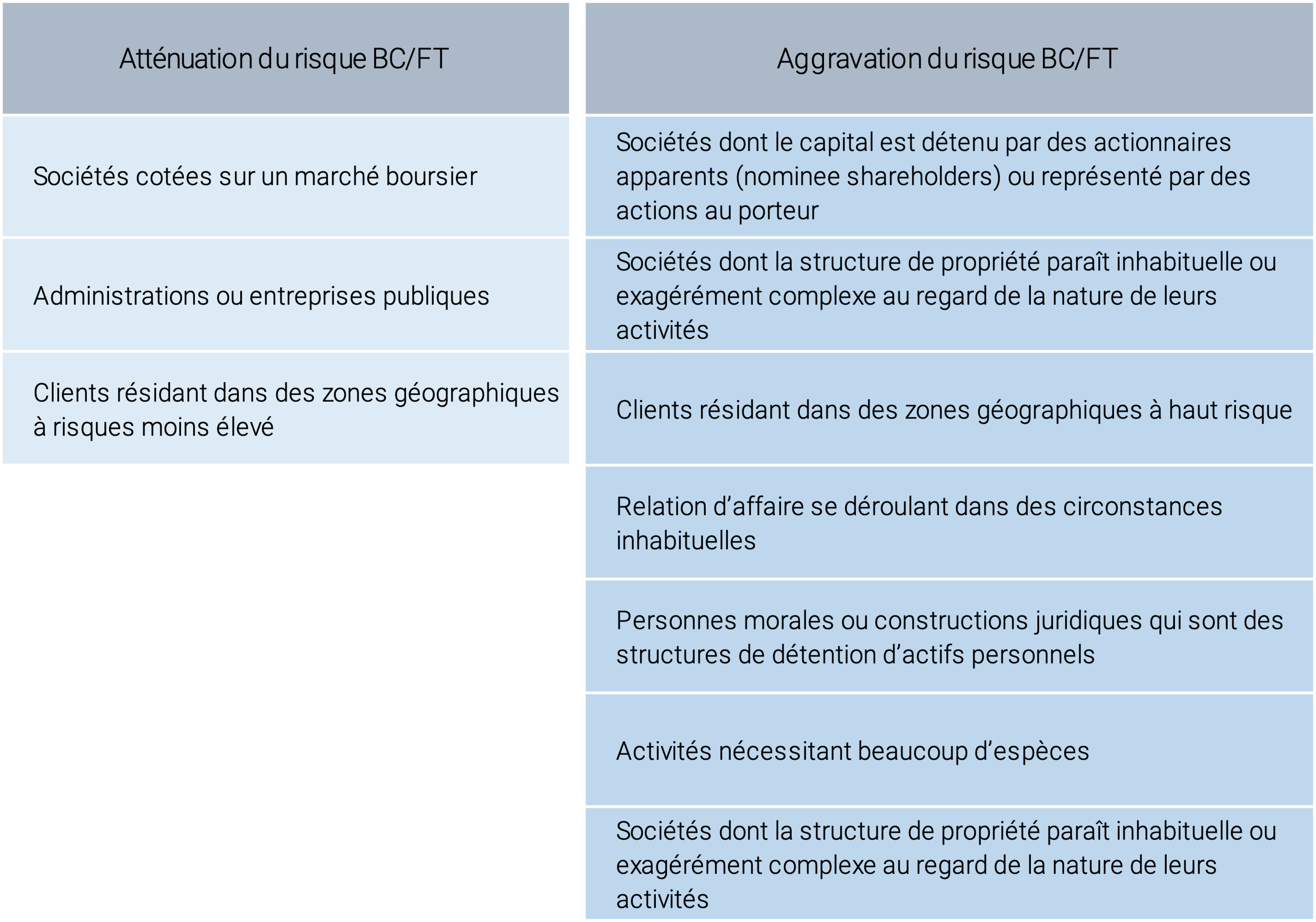

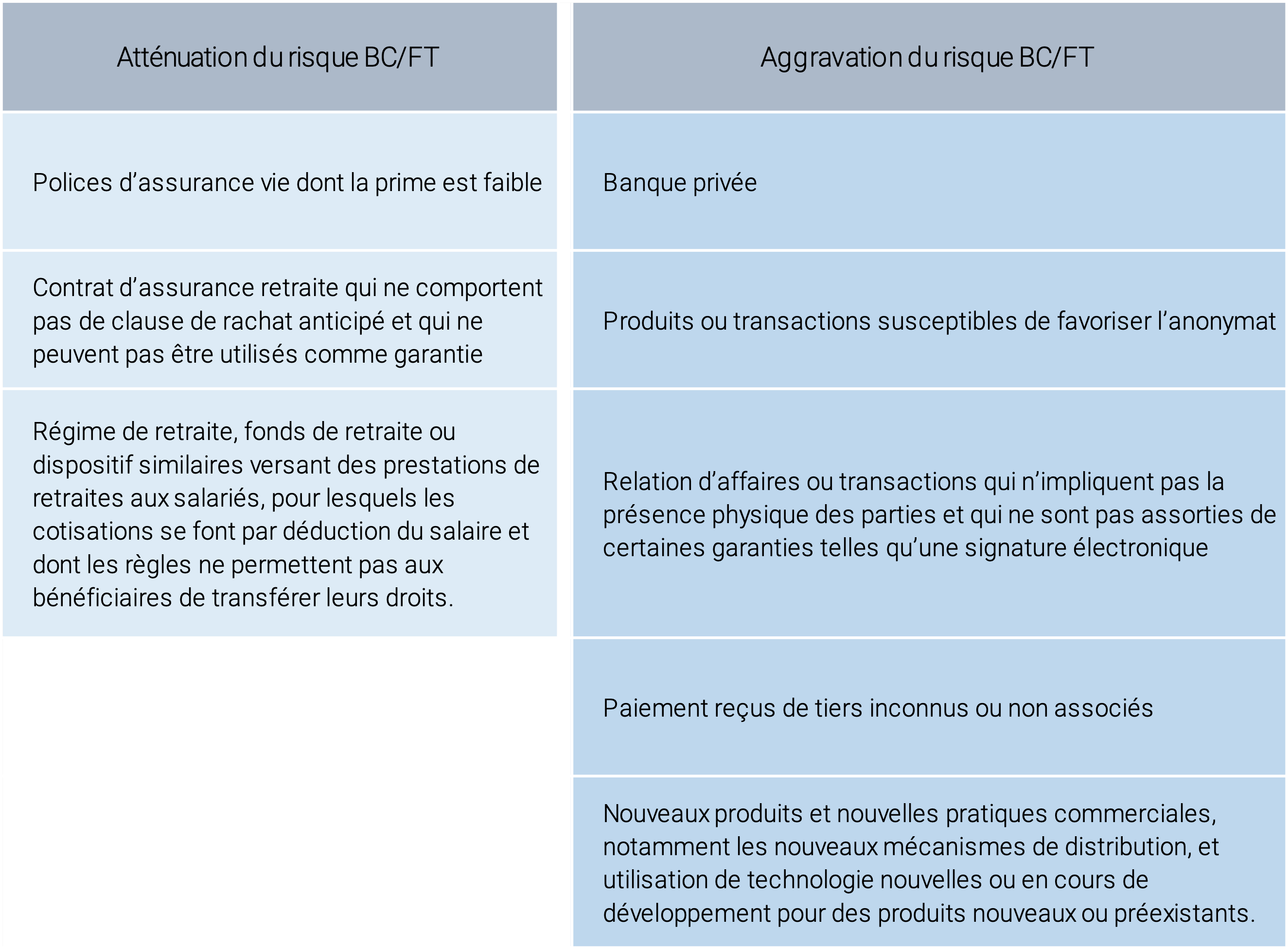

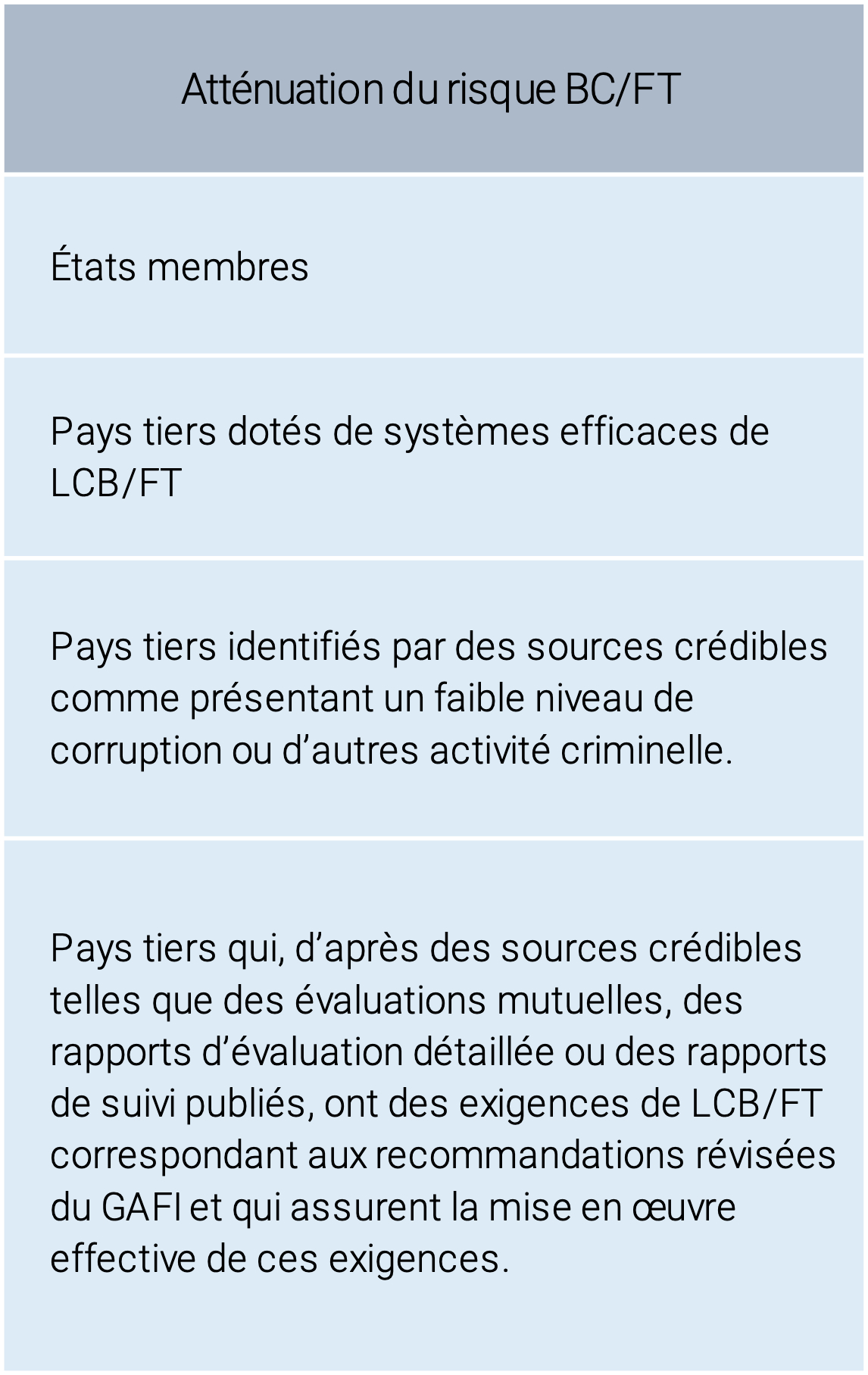

La règlementation attend, de la part des établissements assujettis, la mise en place d’un dispositif qui a pour principal objet l’identification et l’évaluation des risques de blanchiment des capitaux et de financement du terrorisme. Ils doivent s’assurer de l’intégration d’un ensemble d’éléments au sein de leur activité telle qu’une approche fondée sur les risques en tenant compte de mesures de vigilance (simplifiées, normales, renforcées et complémentaires) et de facteurs inhérents aux clients, aux produits, services, transactions et canaux de distribution, ainsi qu’aux facteurs géographique (cf. tableau 1, 2, 3). Par ailleurs, ils doivent également s’assurer de l’existence de politiques, de contrôles et procédures relatifs à ces mesures, aux déclarations de soupçons, à la gestion du respect des obligations ainsi que, dans certains cas, la nomination d’un responsable du dispositif et de son contrôle.

La règlementation attend, de la part des établissements assujettis, la mise en place d’un dispositif qui a pour principal objet l’identification et l’évaluation des risques de blanchiment des capitaux et de financement du terrorisme. Ils doivent s’assurer de l’intégration d’un ensemble d’éléments au sein de leur activité telle qu’une approche fondée sur les risques en tenant compte de mesures de vigilance (simplifiées, normales, renforcées et complémentaires) et de facteurs inhérents aux clients, aux produits, services, transactions et canaux de distribution, ainsi qu’aux facteurs géographique (cf. tableau 1, 2, 3). Par ailleurs, ils doivent également s’assurer de l’existence de politiques, de contrôles et procédures relatifs à ces mesures, aux déclarations de soupçons, à la gestion du respect des obligations ainsi que, dans certains cas, la nomination d’un responsable du dispositif et de son contrôle.

Les mesures de vigilance ainsi que les facteurs soulevés précédemment sont des points de surveillances permettant d’assurer un cadre préventif par l’entreprise en réponse aux exigences réglementaires. Elles permettent d’évaluer l’exposition aux risques BC/FT de chaque individu (client, bénéficiaire effectif, client occasionnel) notamment en déterminant le profil de risque BC/FT. Ces critères sont cumulatifs, mais il n’est pas nécessaire d’avoir l’ensemble pour déterminer un risque fort de BC/FT. Par exemple, une opération complexe, la non-identification d’un bénéficiaire effectif, l’encaissement d’espèces, le cumul d’encaissement de chèques de tiers dépassant des seuils…sont autant de critères qui constituent des faisceaux d’indices et accroissent aussi bien le risque BC/FT que la suspicion de BC/FT.

Quels sont les apports de l’IA pour la LCB/FT ?

Dans son rapport « Intelligence artificielle enjeux pour le secteur financier » l’Autorité de Contrôle et de Résolution Prudentiel (ACPR) souligne comment l’instrumentalisation de l’IA[2] peut renforcer les dispositifs LCB/FT des entreprises assujetties : « Pour les secteurs de la banque et de l’assurance, l’identification de fraudes documentaires, la lutte contre le blanchiment et le financement du terrorisme sont des domaines d’usages récurrents de l’intelligence artificielle. Les techniques d’IA sont notamment employées pour la reconnaissance, l’analyse et la validation des documents fournis. Les algorithmes développés dans ce domaine sont généralement mûrs et déjà intégrés dans nombre de processus de contrôle. »[3].

Ces nouvelles approches d’exploitation des données à caractère personnel sont une nouvelle fois facilitées par le parlement européen. En effet, dans la continuité de la 4ème directive, le RGPD[4] permet la mise en place de nouvelles approches d’exploitations des données à des fins de prévention via la directive (UE) 2016/680, seule exception qu’octroie le RGPD « …Lorsque le traitement de données à caractère personnel par des organismes privés relève du champ d’application du présent règlement, celui-ci devrait prévoir la possibilité pour les États membres, sous certaines conditions, de limiter par la loi certaines obligations et certains droits lorsque cette limitation constitue une mesure nécessaire et proportionnée dans une société démocratique pour garantir des intérêts spécifiques importants tels que la sécurité publique, ainsi que la prévention et la détection des infractions pénales, les enquêtes et les poursuites en la matière ou l’exécution de sanctions pénales, y compris la protection contre les menaces pour la sécurité publique et la prévention de telles menaces. Cela est pertinent, par exemple, dans le cadre de la lutte contre le blanchiment d’argent ou des activités des laboratoires de police scientifique. »[5] De plus, le régulateur français souligne notamment les apports suivants de l’utilisation de l’IA[6] : – Une meilleure compréhension des besoins des clients (Protection des intérêts clients) – Une meilleure compréhension des offres de produits et de services par le client ou le conseiller (Protection des intérêts client) – Une amélioration de la qualité des processus de détection du blanchiment (LCB/FT) – Une meilleure gestion des risques par la contribution à l’aide de la prise de décision (Risque) – Des économies d’échelle par l’automatisation de tâches répétitives et amélioration de l’organisation des processus (Maîtrise des coûts).

En quoi consiste la mise en place de modèles de Machine Learning (ML) au regard de la LCB/FT ?

Les techniques d’IA actuellement employées[7] au regard de la LCB/FT ne concernent pas encore la modélisation de données pour construire des modèles prédictifs de Machine Learning. Aussi bien à l’entrée en relation d’affaires qu’au cours de la relation d’affaires, la surveillance du risque BC/FT via les outils du Machine Learning et sa maîtrise sont appelées à être mises en œuvre sous couvert de certaines conditions pour être performantes, efficaces, explicables et auditables. La préparation des données à intégrer est aussi sensible que la phase d’apprentissage des modèles de Machine Learning. En effet, cette dernière consiste à définir les problématiques et à déterminer les phénomènes à retenir correspondant à la détection de signaux faibles soient-ils de blanchiment de capitaux et financement du terrorisme.

Les techniques d’IA actuellement employées[7] au regard de la LCB/FT ne concernent pas encore la modélisation de données pour construire des modèles prédictifs de Machine Learning. Aussi bien à l’entrée en relation d’affaires qu’au cours de la relation d’affaires, la surveillance du risque BC/FT via les outils du Machine Learning et sa maîtrise sont appelées à être mises en œuvre sous couvert de certaines conditions pour être performantes, efficaces, explicables et auditables. La préparation des données à intégrer est aussi sensible que la phase d’apprentissage des modèles de Machine Learning. En effet, cette dernière consiste à définir les problématiques et à déterminer les phénomènes à retenir correspondant à la détection de signaux faibles soient-ils de blanchiment de capitaux et financement du terrorisme.

Il existe deux méthodes d’apprentissage : le supervisé et le non-supervisé. La première permet de catégoriser les alertes paramétrées en fonctions de critères tels que les mesures de vigilance et les facteurs de risques énoncés dans la 4ème directive. Le non-supervisé quant à lui permet à partir de schémas standards[8] de faire ressortir dans ce cas de figure des évènements rares (dits outliers) à analyser pour déterminer si le risque BC/FT est avéré ou non. Ces exploitations de données deviennent un préalable à l’identification d’occurrences à risque que l’établissement complétera d’une analyse humaine et permettra ainsi la constitution de déclarations de soupçons. Le Machine Learning rejoint ainsi les outils de filtrage, balayage et criblage utilisés aujourd’hui dans la détection et prévention des risques BC/FT.

Que sont les risques et contraintes opérationnelles du Machine Learning au regard de la LCB/FT ?

Les risques et contraintes opérationnelles du Machine Learning ne sont pas spécifiques à la LCB/FT. La mise en place, la conformité et l’efficacité des nouvelles approches nécessitent une démarche de transformation/adaptation du software et du hardware de l’entreprise. Pour pouvoir prétendre à la fiabilité, la solidité, et ainsi la crédibilité des résultats découlant de ces algorithmes, l’entreprise assujettie doit gérer les risques liés. Ils sont encore nombreux comme la présence de biais dans le traitement des données ou, la mauvaise qualité des données (biais dans les données collectées, biais dans les sources utilisées, la faible pertinence des données retenues face aux objectifs visés, la complétude), et potentiellement le phénomène d’exclusion.

Le problème spécifique à la LCB/FT que pose l’utilisation des algorithmes de Machine Learning se situe dans sa phase d’apprentissage autonome qui potentiellement faciliterait des dérives comme la non détection de transactions suspectes et la raison de l’exclusion de ces transactions. De ce fait, l’apprentissage de ces algorithmes appelle à être encadré, afin de réduire ce risque. Il est appelé à s’intensifier au fur et à mesure de l’intégration de nouvelles données qui alimentent les algorithmes, ce qui ne va pas dans le sens d’un établissement assujetti dont le principal objectif est notamment d’encadrer, maîtriser, réduire et assurer une gestion des risques BC/FT.

De plus, les freins d’utilisation du Machine Learning par l’industrie financière sont essentiellement l’opacité et le manque d’auditabilité des algorithmes, l’effet « boîte noire ». Ces deux risques sont soulignés par le Financial Stability Board (FSB) qui préconise notamment de combiner les modèles traditionnels et les modèles d’IA via des simulations, ou bien d’utiliser l’IA sur des périmètres limités réduisant ainsi cet effet[9].

Afin de garantir aussi bien leur explicabilité, leur auditabilité, leur exploitation que leur autonomie, l’encadrement de ces nouvelles méthodologies par un administrateur de sécurité est nécessaire[10]. Cependant, se pose la question des personnes habilitées au contrôle de ces modèles d’IA, sur leur construction, modélisation, utilisation et fonctionnement. Si les différentes fonctions de l’IA regroupent les personnes adéquates pour la mise en place et la mise en œuvre de ces modèles[11], ils ne peuvent être juges et parties. De la même manière, les personnes clés de la gouvernance des données ne peuvent prétendre à la mise en œuvre de l’audit de ces algorithmes. Aussi bien le Chief Data Officer (CDO) facilitateur d’accès aux données et analyste des données pertinentes à retenir selon la demande, que le Chief Data Quality Officer (CDQO) responsable de la qualité des données utilisées n’ont pas la capacité et le pouvoir de contrôler les algorithmes du Machine Learning employés. Dans les métiers de l’IA, il n’existe pas de métiers correspondant à une fonction de contrôle au sens de l’audit. En l’absence de formation, les contrôleurs permanent comme les auditeurs internes et les auditeurs informatiques n’ont pas non plus la connaissance suffisante pour contrôler les composantes du Machine Learning. De nouveaux profils hybrides sont attendus sur ce périmètre.

En amont de ces risques, des contraintes opérationnelles sont à prendre en compte pour faciliter la mise en place d’une solution basée sur le Machine Learning (source: Machine-learning-for-computer-security-abeaugnon-pchifflier-anssi)

Efficacité : La définition des faux positifs (fausses alertes) et des faux négatifs (vraies alertes non considérées comme telles) doit être qualitative. S’il y a trop de faux positifs, les opérateurs de sécurité vont être noyés d’occurrences à traiter et auront moins de temps pour analyser les plus importants. En revanche, les faux négatifs peuvent causer de graves dommages au système défendu.

Transparence : Elle est cruciale pour les administrateurs de sécurité et les opérateurs. Les opérateurs de sécurité ont besoin d’information sur les raisons pour lesquelles une alerte a été déclenchée afin d’évaluer sa criticité et d’éliminer les faux positifs. De plus, les administrateurs de la sécurité ne déploieront pas de méthodes de détection basées sur des boîtes noires. Ils veulent comprendre comment les méthodes de détection fonctionnent pour leur faire confiance avant leur déploiement.

Auditabilité : Les administrateurs de la sécurité doivent vérifier le contrôle de la détection. Ils doivent pouvoir les mettre à jour pour corriger immédiatement les erreurs potentielles. La mise à jour des méthodes de détection doit être simple, car la rapidité est cruciale pour détecter les menaces émergentes dès que possible.

Robustesse : Les méthodes de détection sont déployées dans des environnements contradictoires : les comportements malveillants évoluent constamment au fur et à mesure que les attaquants tentent de tromper les détecteurs. Les méthodes de détection doivent donc être conçues pour résister aux tentatives d’évasion. Cette contrainte est liée à l’efficacité mais concerne la capacité à détecter les comportements malveillants spécialement conçus pour échapper à une méthode de détection donnée. Évaluer la robustesse signifie évaluer dans quelle mesure la performance de la détection diminue lorsque des attaquants modifient légèrement les comportements malveillants dans le but d’une détection trompeuse.

En conclusion l’IA peut apporter une vraie réponse de développement à la LCB/FT comme le bénéfice de la digitalisation au KYC et à la relation client. L’entreprise assujettie peut ainsi considérer un renforcement de son dispositif LCB/FT et notamment l’implosion de ses techniques de balayage / filtrage / criblage de ses bases de données. L’automatisation de la détection de risques BC/FT qu’apporte le Machine learning par la combinaison de facteurs de risques et scénarii est un nouveau champ d’exploitation qui permet d’approfondir l’analyse du risque BC/FT. Il en ressort des gains de temps, une détection plus fiable et une réactivité optimisée (réduction des délais) face à un risque BC/FT au regard des transactions.

L’utilisation des outils du Machine Learning au service de la LCB/FT passe par la modélisation d’algorithmes se servant de données sensibles et primordiales telles que les données sur l’identification du client, l’origine et la destination des fonds, le comportement du client, ou encore la compilation et combinaison de données (transactions, actions, réactions, observations…). Le FSB est favorable à la conservation des méthodologies traditionnelles mais s’attend à un renforcement des dispositifs de LCB/FT avec ce qu’offre l’IA. L’ACPR voit d’un très bon œil l’utilisation des nouvelles technologies à des fins de prévention, et comprend les freins des différents acteurs assujettis. Il a notamment développé un pôle dédié à la supervision des Fintechs notamment leur agrément et au suivi des risques induits par les nouvelles innovations qu’ils proposent dans le système bancaire et financier pour acculturer notamment les acteurs financiers. De plus, TRACFIN[12] souligne les bénéficies du Machine Learning. Il est le seul cas d’usage communiqué à ce jour, dans l’exercice de ses fonctions[13]. L’IA lui a notamment permis des gains de temps, de couverture, d’identification et de traitement de masse de déclarations de soupçon (80 000 vs 10 000 alertes). Dans son interview, il présente la manière dont il a appréhendé le Machine Learning dans son activité et sécurisé son sujet avec notamment une plateforme française Dataiku qui permet de structurer l’activité de ses Data Scientists et de protéger son activité. Par ailleurs, il a prioritairement opté à la sécurité des données stockées sur ses serveurs ainsi qu’à l’étanchéité avec les systèmes d’alimentation des données externes. Cette architecture a notamment fait l’objet d’une validation par l’ANSSI.

N’ayant pas le même positionnement et pouvoir, les établissements assujettis peuvent s’en inspirer pour avancer dans l’intégration du Machine Learning dans leur dispositif de prévention. Mais aucune information relative au contrôle de ces algorithmes de Machine Learning n’est évoquée. Tant que l’activité de contrôle de cette nouvelle approche n’est pas clairement définie permettant d’atténuer les risques d’expulsion, d’écarter l’effet boîte noire et les biais qu’engendrent le Machine Learning, ces nouvelles technologies seront difficilement embarquées. Par ailleurs, des pistes de réflexion et recommandations[14] ont été soulevées comme le développement d’une capacité nationale de traitement de masse dans la continuité des performances soulevées par les travaux de TRACFIN[12]. Une démarche du législateur national voir européen semble attendue pour faciliter la gouvernance des nouvelles méthodologies de LCB/FT.

Ilhem TEJ

Principal Financial Services Consulting Compliance & Regulatory

Tableau 1 – Facteurs de risque et types d’éléments inhérents aux clients

Source : Annexe II et III (UE) 2015/849.

Tableau 2 – Facteurs de risque et types d’éléments liés aux produits, aux services, aux transactions ou aux canaux de distribution

Source : Annexe II et III (UE) 2015/849.

Tableau 3 – Facteurs de risque et types d’éléments liés aux produits, aux services, aux transactions ou aux canaux de distribution

Source : Annexe II et III (UE) 2015/849.

[1] Source Directive (UE) 2015/849 du parlement européen et du conseil du 20 mai 2015 – [2] L’IA est une notion polysémique, dans le cadre de cet article elle se restreint à des programmes qui disposent au minimum d’une capacité d’apprentissage autonome, autrement dit aux algorithmes de Machine Learning. – [3] ACPR – Mars 2018 (p.14) – [4] Règlement européen (UE) 2016/679 relatif à la protection des personnes physiques à l’égard du traitement des données à caractère personnel et à la libre circulation de ces données ; – [5] Règlement (UE) 2016/679 – RGPD – Considération 19. – [6]Intelligence artificielle enjeux pour le secteur financier – ACPR – Mars 2018 (p.12) – [7]Livre Blanc « Intelligence artificielle, blockchain et technologies quantiques au service de la finance de demain » – DIP 7 – avril 2019. – [8] Scénarii puisés notamment dans les sanctions du régulateurs et rapports annuels de Tracfin au-dela des facteurs de risque BC/FT. – [9] FSB – Financial Stability Implications from FinTech – June 2017 (p.56) – [10] https://www.ssi.gouv.fr/publication/machine-learning-for-computer-security-conference-cesar/ Comme le souligne l’ANSSI, cette personne est différente de l’opérateur de sécurité, elle peut-être un Responsable de la Sécurité des Systèmes d’Information (RSSI) ou une personne tel qu’un Data-Scientiste ou encore un contrôleur permanent des systèmes informatiques. Tout dépend de l’organisation de l’entreprise assujettie. – [11] Data scientist, Data analyst, Data ingénieur – Intelligence artificielle enjeux pour le secteur financier – ACPR – Mars 2018 (p. 32) – [12] Cellule de Renseignement Financier Français [13] Big Data : comment Tracfin remonte les filières de blanchiment d’argent sale. https://www.lemagit.fr/etude/Comment-Tracfin-remonte-les-filieres-de-financement-de-Daech-avec-le-Big-Data. – [14] DIP 7 du livre blanc de Finance Innovation [15] https://www.lemagit.fr/etude/Comment-Tracfin-remonte-les-filieres-de-financement-de-Daech-avec-le-Big-Data

Suivez-nous sur les réseaux sociaux !

Suivez-nous sur les réseaux sociaux !

Suivez-nous

sur les réseaux sociaux !

© 2021 OPERANKA ASSOCIATES

Mentions légales Conditions générales d’utilisation Données personnelles © 2021 OPERANKA ASSOCIATES